Małe Modele Językowe (SLM): Rewolucja Efektywności i Prywatności w 2026 roku

Małe Modele Językowe (SLM) to fundament nowej ery sztucznej inteligencji, oferujący wydajność zbliżoną do gigantycznych modeli przy ułamku kosztów operacyjnych, zerowych opóźnieniach i pełnej suwerenności danych. W 2026 roku strategiczny zwrot w stronę „right-sizingu” – czyli doboru modelu o optymalnej skali do konkretnego zadania – staje się kluczowym czynnikiem przewagi konkurencyjnej w biznesie i technologii.

Optymalizacja zamiast gigantyzmu: Nowy paradygmat AI

Era dominacji wyłącznie potężnych, ale ociężałych Dużych Modeli Językowych (LLM) dobiega końca. Przejście na Małe Modele Językowe wynika z konieczności przełamania barier sprzętowych oraz rosnącego zapotrzebowania na prywatność. SLM, definiowane zazwyczaj jako jednostki o parametrach od kilkuset milionów do ok. 30 miliardów, pozwalają na błyskawiczny fine-tuning i dostarczanie wyspecjalizowanej wiedzy eksperckiej w niszowych domenach, takich jak prawo czy medycyna.

W przeciwieństwie do ogólnych modeli GPT i ChatGPT, które wymagają potężnej infrastruktury chmurowej, SLM eliminują ryzyka opóźnień (latency) oraz krytyczne luki w bezpieczeństwie, pracując bezpośrednio na urządzeniach końcowych. To podejście pozwala firmom budować własne, autonomiczne bazy wiedzy bez przesyłania wrażliwych danych na zewnętrzne serwery.

Środowiskowy koszt inteligencji a zrównoważony rozwój

Wybór SLM to nie tylko decyzja technologiczna, ale i ekologiczna: mniejsza skala modelu oznacza drastyczną redukcję śladu węglowego i zużycia zasobów naturalnych przez centra danych. Podczas gdy trenowanie gigantycznych systemów pochłania tysiące megawatogodzin energii i miliardy galonów wody do chłodzenia, pojedyncze zapytanie do SLM generuje od 10 do 50 razy mniej emisji CO2e.

Dla organizacji wdrażających strategie ESG, Małe Modele Językowe są jedynym sposobem na skalowanie inteligencji przy minimalnym nakładzie energetycznym. Pozwala to uniknąć przyszłych „podatków węglowych” od AI i budować wizerunek odpowiedzialnego innowatora. Zrozumienie, jak działają te mechanizmy, wymaga powrotu do podstaw tego, czym są sieci neuronowe i ich budowa.

Architektura wydajności: Pruning i metoda DISP-LLM

Pruning strukturalny umożliwia usuwanie zbędnych parametrów z sieci neuronowej bez niszczenia jej zdolności do rozumowania, co pozwala na uruchamianie zaawansowanej inteligencji na urządzeniach mobilnych. Przełomem w tym obszarze jest metoda DISP-LLM (Dimension-Independent Structural Pruning). Pozwala ona na zwiększenie przepustowości modeli nawet o 50% przy jednoczesnej redukcji kosztów wdrożenia, co czyni ją od 14 do 27 razy tańszą niż tradycyjne rozwiązania chirurgiczne dla modeli.

Dzięki DISP-LLM, inżynierowie mogą błyskawicznie prototypować AI pod konkretne jednostki sprzętowe. Jest to klucz do miniaturyzacji technologii, która zachowuje logikę i precyzję odpowiedzi, mimo mniejszej liczby warstw obliczeniowych.

Kwantyzacja: Klucz do lokalnego uruchamiania modeli

Kwantyzacja redukuje precyzję numeryczną wag modelu, co drastycznie zmniejsza zapotrzebowanie na pamięć VRAM i umożliwia pracę z AI na domowych stacjach roboczych. Dzięki technikom takim jak GGUF czy GPTQ, modele, które dawniej wymagały profesjonalnych serwerowni, dziś mieszczą się w pamięci nowoczesnych laptopów.

| Format | Główne zastosowanie | Charakterystyka techniczna |

| GGUF | CPU / Apple Silicon | Umożliwia layer offloading do GPU; wysoka elastyczność. |

| GPTQ | GPU (NVIDIA) | 4-bitowa kompresja wag; optymalny dla wysokiej przepustowości. |

| AWQ | Modele instruktorskie | Chroni kluczowe wagi; wyższa jakość w zadaniach logicznych. |

Wykorzystując kwantyzację 4-bitową, nawet zaawansowane modele z rodziny LLaMA stają się dostępne lokalnie. Więcej o terminologii związanej z optymalizacją znajdziesz w naszym słowniku pojęć AI i LLM.

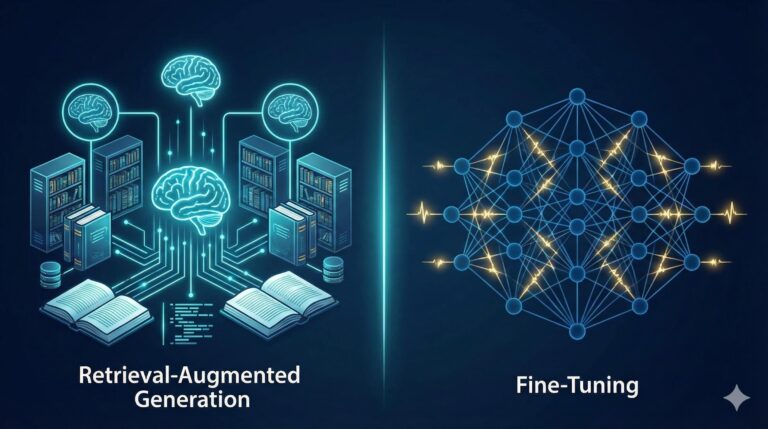

Destylacja wiedzy: Jak uczeń przerasta mistrza

Proces destylacji pozwala na transfer inteligencji z potężnego modelu „nauczyciela” do zwinnego modelu „studenta”, zachowując ponad 95% wydajności przy ułamku wielkości. Wykorzystuje się tu m.in. technikę RBKD (Rationale-Based Knowledge Distillation), gdzie mniejszy model uczy się nie tylko gotowych odpowiedzi, ale całego procesu rozumowania (Chain-of-Thought).

Dzięki zastosowaniu danych syntetycznych wysokiej jakości, trenowanie SLM na precyzyjnie dobranych zestawach danych („perełkach”) jest dziś bardziej efektywne niż przeszukiwanie całego, zaśmieconego internetu. Pozwala to na stworzenie floty wyspecjalizowanych agentów, którzy w swoich dziedzinach dorównują najdroższym modelom chmurowym.

Liderzy ekosystemu SLM w 2026 roku

Na rynku dominuje kilka serii modeli, które definiują standardy wydajności:

- Microsoft Phi Series: Niekwestionowani liderzy w stosunku parametrów do zdolności logicznych. Phi-4 oferuje niespotykaną sprawność w analityce i kodowaniu.

- Google Gemma: Modele natywnie zoptymalizowane pod ekosystem Android, wprowadzające multimodalność (obsługę obrazu i tekstu) bezpośrednio na smartfony.

- Alibaba Qwen: Najlepszy wybór dla programistów; wersje Coder oferują sprawność w generowaniu kodu Python/C++ porównywalną z gigantami.

Wdrożenie lokalne i Edge AI: Suwerenność danych w praktyce

Wdrożenie Local-First AI oparte na Małych Modelach Językowych to jedyny sposób na pełną ochronę prywatności w sektorach takich jak finanse czy medycyna. Wykorzystanie dedykowanych jednostek NPU (Neural Processing Unit) w nowoczesnych procesorach pozwala na pracę w trybie całkowicie odciętym od sieci (air-gapped).

Aby skutecznie wdrożyć SLM w swojej infrastrukturze, należy skupić się na trzech krokach:

- Weryfikacja dostępnej pamięci VRAM/NPU.

- Wybór odpowiedniego frameworka (np. Ollama lub bitnet.cpp dla maksymalnej oszczędności energii).

- Całkowite wyłączenie telemetrii w celu zapewnienia suwerenności obliczeniowej.

Przyszłość należy do wyspecjalizowanych agentów

W 2026 roku era monolitów AI ustępuje miejsca „rozproszonym stadom agentowym”. Zamiast jednego modelu do wszystkiego, przyszłość to ekosystemy, w których dziesiątki małych, szybkich i energooszczędnych modeli współpracują ze sobą. Takie podejście redukuje koszty operacyjne o 80-90%, zachowując najwyższą jakość finalnej syntezy danych. Sukces w dzisiejszym świecie technologii nie zależy już od skali, ale od precyzji i inteligentnej optymalizacji zasobów.