Jak NotebookLM rozwiązuje problem halucynacji

Główne modele językowe zrewolucjonizowały dostęp do informacji, ale ich działanie obarczone jest ryzykiem błędu. Zjawisko znane jako halucynacje AI polega na generowaniu fałszywych, choć wiarygodnie brzmiących danych. W kontekstach profesjonalnych zmyślone fakty stanowią realne zagrożenie, dlatego Google opracowało narzędzie oparte na architekturze, która ogranicza wiedzę asystenta wyłącznie do dokumentów dostarczonych przez użytkownika.

Czym są halucynacje AI i jak NotebookLM halucynacje ogranicza?

NotebookLM rozwiązuje problem błędnych odpowiedzi poprzez zastosowanie architektury Source-Grounding (ugruntowanie w źródłach). W przeciwieństwie do tradycyjnych modeli, to narzędzie analizuje wyłącznie Twoje prywatne pliki PDF czy notatki. Dzięki temu NotebookLM halucynacje pojawiają się znacznie rzadziej, ponieważ odpowiedzi są zakotwiczone w konkretnym kontekście dostarczonych materiałów.

Kluczem jest technologia RAG (Retrieval-Augmented Generation). Pozwala ona modelowi na dostęp do specyficznych danych w czasie rzeczywistym, co czyni go bezpieczniejszym od ogólnych botów. Jeśli chcesz lepiej zrozumieć terminologię stosowaną w architekturze nowoczesnych systemów, sprawdź mój słownik pojęć AI i LLM, który wyjaśnia te mechanizmy.

Fundament zaufania: Mierzalna poprawa dzięki cytatom

Największą siłą tego systemu jest automatyczne generowanie cytatów i odnośników do źródła. Każda teza postawiona przez model jest opatrzona numerem referencyjnym, co pozwala na natychmiastową weryfikację. To sprawia, że NotebookLM halucynacje są łatwe do wykrycia, nawet jeśli się pojawią.

Takie podejście zmienia dynamikę pracy:

- Weryfikowalność: Nie musisz wierzyć maszynie na słowo – możesz sprawdzić ją w sekundę

- Transparentność: Model jasno wskazuje, skąd czerpie wiedzę, co buduje autorytet treści.

- Bezpieczeństwo danych: Narzędzie działa w zamkniętym ekosystemie Twoich materiałów.

Warto porównać to podejście z tym, co oferują inne popularne rozwiązania. Więcej o tym, jak działają konkurencyjne systemy, przeczytasz w moim przewodniku po modelach GPT i ChatGPT.

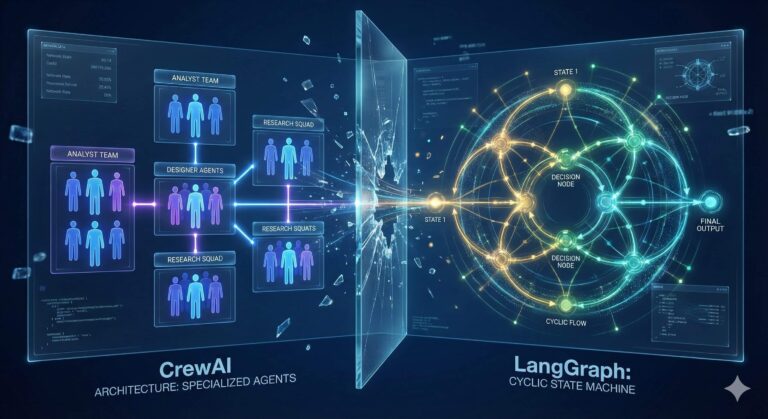

Porównanie: Tradycyjne AI vs NotebookLM

Poniższa tabela przedstawia kluczowe różnice w podejściu do faktów i źródeł między standardowymi modelami a narzędziem od Google.

| Cecha | Tradycyjny Model (np. ChatGPT) | Google NotebookLM |

| Główne źródło wiedzy | Dane treningowe (cały internet) | Dokumenty przesłane przez użytkownika |

| Ryzyko halucynacji | Wysokie (brak danych) | Bardzo niskie (ograniczone do źródeł) |

| System cytowania | Często brak lub linki ogólne | Precyzyjne odnośniki do fragmentów tekstu |

| Główny cel | Kreatywność i ogólna pomoc | Analiza, synteza i praca badawcza |

Ograniczenia modelu: Gdzie NotebookLM halucynacje wciąż mogą wystąpić?

Mimo swojej potęgi, narzędzie to nie jest pozbawione wad. Jeśli dostarczysz mu niekompletne lub błędne dane, model powieli te błędy zgodnie z zasadą „garbage in, garbage out”. Choć technologia ta minimalizuje błędy, użytkownik wciąż musi zachować czujność.

Dodatkowe wyzwania obejmują:

- Brak wiedzy zewnętrznej: NotebookLM nie przeszuka za Ciebie internetu w celu znalezienia nowych informacji.

- Zależność od jakości transkrypcji: W przypadku analizy wideo, narzędzie opiera się wyłącznie na tekście – błędy w napisach oznaczają błędy w analizie.

- Limity technologiczne: Darmowa wersja ogranicza liczbę źródeł, co przy dużych projektach może być barierą.

Aby dowiedzieć się, jak w praktyce wdrożyć ten system do swoich zadań, zapoznaj się z moim szczegółowym artykułem: Google NotebookLM – kompletny przewodnik po Deep Research.

Przyszłość ugruntowanej inteligencji

NotebookLM dokonuje świadomego wyboru: rezygnuje z błyskotliwej improwizacji na rzecz rygorystycznej wierności faktom. W świecie zdominowanym przez nadmiar informacji, taka „smycz” założona na algorytmy staje się koniecznością dla każdego profesjonalisty. Zamiast dostarczać zmyślonych odpowiedzi, narzędzie to oferuje solidne wsparcie, które pozwala skupić się na wyciąganiu wartościowych wniosków.