PydanticAI vs LangChain: Co Wybrać do Produkcji AI w 2026?

Wybór między PydanticAI vs. LangChain w 2026 roku nie jest już kwestią preferencji estetycznych, lecz decyzją o stabilności systemów klasy Enterprise. Globalni liderzy technologii finansowych i medycznych masowo migrują swoje rozwiązania z LangChain na rzecz PydanticAI, redukując liczbę błędów typu runtime o ponad 60% dzięki natywnemu bezpieczeństwu typów i jawnej orkiestracji kodu. Ten zwrot paradygmatu pokazuje, że era „magicznych” abstrakcji ustępuje miejsca rygorystycznej inżynierii, gdzie przewidywalność formatu danych jest ważniejsza niż szybkość budowania pierwszego prototypu.

Transformacja frameworków: Od fascynacji prototypem do rygoru produkcji

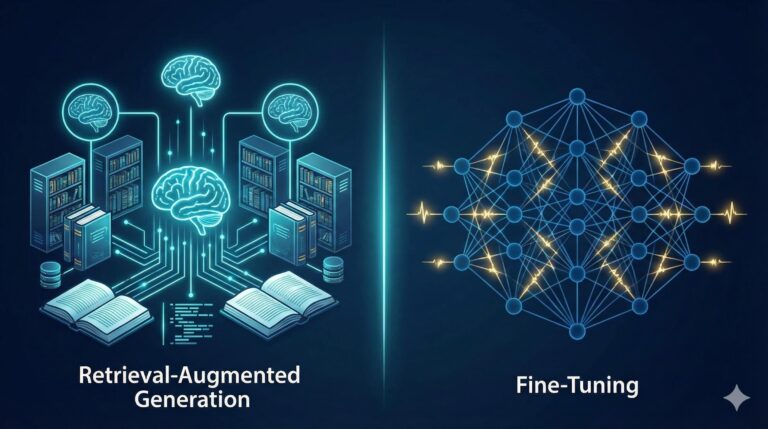

Wczesna faza rozwoju aplikacji opartych o zaawansowane modele LLM była zdominowana przez potrzebę natychmiastowych efektów. Narzędzia takie jak LangChain idealnie wpisały się w ten trend, oferując setki gotowych „klocków”. Jednak w środowisku produkcyjnym, gdzie każdy błąd generuje koszty, te same abstrakcje stały się barierą.

Inżynierowie coraz częściej dostrzegają, że ukrywanie logiki wewnątrz nieprzejrzystych łańcuchów (Chains) uniemożliwia skuteczne testowanie. PydanticAI reprezentuje podejście code-first, traktując agenta jako standardowy obiekt Python. Dzięki temu procesy takie jak techniki inżynierii promptów stają się częścią kontrolowanego cyklu życia oprogramowania, a nie „czarną skrzynką”.

Architektura jawności kontra „magia” abstrakcji

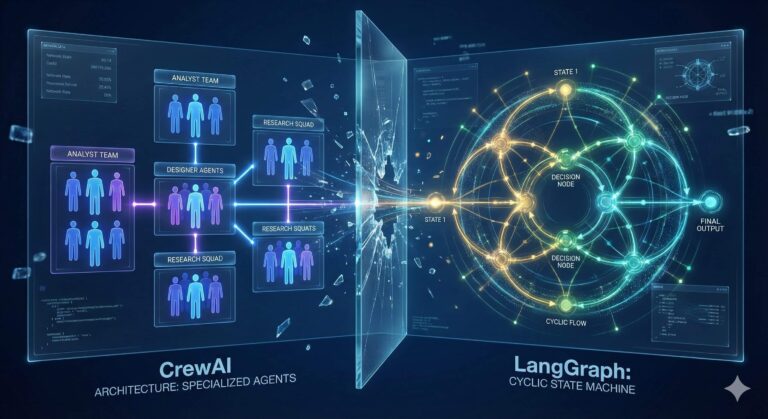

Różnica w filozofii obu frameworków determinuje długoterminowy koszt utrzymania projektu. LangChain opiera się na własnym języku deklaratywnym (LCEL), który, choć elegancki w teorii, w praktyce utrudnia debugowanie. Z kolei PydanticAI wykorzystuje to, co programiści znają najlepiej: czysty kod i dekoratory.

| Cecha | LangChain (Podejście „Magic”) | PydanticAI (Podejście „Code-first”) |

| Orkiestracja | Łańcuchy, LCEL, Grafy | Jawna logika Python, funkcje |

| Walidacja danych | Często post-factum (parsery) | Natywna i natychmiastowa |

| Zarządzanie stanem | Niejawne (moduły pamięci) | Jawne modele Pydantic |

| Krzywa uczenia | Niska na start, wysoka przy błędach | Stała, oparta na wzorcach inżynierii |

Z naszego doświadczenia wynika, że zespoły, które wybierają strukturę zamiast magii, znacznie szybciej osiągają etap Product-Market Fit, ponieważ ich systemy są po prostu łatwiejsze do optymalizacji.

Rozwiązanie problemu halucynacji formatu danych

Największym wyzwaniem w produkcji AI są sytuacje, w których model generuje poprawną merytorycznie treść, ale w błędnym formacie (np. tekst zamiast JSON). PydanticAI eliminuje to ryzyko poprzez parametr result_type. Framework gwarantuje, że wyjście z modelu zawsze zostanie zwalidowane względem zdefiniowanej klasy.

Jeśli model popełni błąd, system automatycznie ponawia próbę, przesyłając informację o błędzie walidacji z powrotem do LLM. To sprawia, że zarządzanie danymi w AI staje się deterministyczne. W PydanticAI błąd nie jest „cichy” – deweloper otrzymuje precyzyjny ValidationError, co skraca czas naprawy usterki z godzin do minut.

Bezpieczeństwo typów jako fundament zaufania w systemach krytycznych

W systemach bankowych czy medycznych, zaawansowane modele LLM muszą operować na ściśle określonych danych. PydanticAI wprowadza mechanizm wstrzykiwania zależności (Dependency Injection) poprzez RunContext. Pozwala to na bezpieczne przekazywanie połączeń do baz danych czy kluczy API bezpośrednio do narzędzi agenta, zachowując pełne wsparcie dla autouzupełniania w edytorach kodu.

To podejście buduje filar Wiarygodności (Trustworthiness), który jest kluczowy dla współczesnych systemów rankingowych i zaufania użytkowników. Zamiast polegać na niepewnych słownikach Dict[str, Any], inżynierowie pracują na jawnym schemacie danych, co minimalizuje ryzyko wycieku kontekstu lub błędów typu KeyError na produkcji.

Obserwowalność i debugowanie bez zewnętrznych narzędzi

Kolejnym argumentem w debacie PydanticAI vs. LangChain jest kwestia widoczności procesów. LangChain często wymaga płatnych platform zewnętrznych do podstawowego śledzenia logiki. PydanticAI integruje się bezpośrednio ze standardowym systemem logowania Pythona oraz narzędziem Logfire.

Dzięki temu programista może postawić tradycyjny breakpoint wewnątrz narzędzia agenta i podejrzeć jego stan. Dla inżyniera operacyjnego oznacza to czyste ślady stosu (stack traces), które wskazują bezpośrednio na błąd w kodzie, a nie na dziesiątki warstw wewnętrznych frameworka.

Przyszłość produkcji AI należy do inżynierii, nie do sztuczek

Analizując trendy na rok 2026, widać wyraźnie, że branża odchodzi od narzędzi „do wszystkiego” na rzecz specjalistycznych bibliotek wspierających rygor programistyczny. Wybór PydanticAI to sygnał dojrzałości zespołu. Pozwala on budować agenty AI, które są testowalne, skalowalne i – co najważniejsze – przewidywalne. Profesjonalne wdrożenie wymaga fundamentów, którym można zaufać, a te dostarcza właśnie ustrukturyzowana architektura oparta na walidacji danych.