Kompleksowy Poradnik po AI w Trybie Offline 2026: Architektura, Sprzęt i Suwerenność Danych

Nowy Paradygmat: Od Chmury do Lokalnej Inteligencji

Sztuczna inteligencja offline w 2026 roku staje się fundamentem suwerenności cyfrowej, pozwalając na przetwarzanie wrażliwych danych bez przesyłania ich do zewnętrznych serwerów. Strategiczna zmiana w stronę lokalnej egzekucji (Edge AI) wynika z konieczności ochrony własności intelektualnej i eliminacji opóźnień (latency). Raporty rynkowe wskazują, że organizacje upraszczają architekturę, przetwarzając dane tam, gdzie one powstają, co bezpośrednio rozwiązuje problem tzw. „data gravity”.

Lokalna inteligencja to nie tylko trend, to konieczność w dobie regulacji prawnych. Wykorzystując lokalne systemy, firmy odzyskują pełną kontrolę nad swoimi procesami. Kluczowe jest tutaj zrozumienie, jak sztuczna inteligencja offline wpływa na bezpieczeństwo operacyjne – fizyczna obecność danych wewnątrz chronionego obwodu firmy to obecnie jedyna droga do pełnej ochrony strategicznych zasobów. Warto w tym miejscu zgłębić podstawowe bezpieczeństwo AI, aby zrozumieć skalę ryzyk związanych z modelem chmurowym.

Strategiczne Drivery AI Offline: Więcej niż Oszczędność

Wdrażanie systemów offline w 2026 roku jest podyktowane transformacją wydatków operacyjnych (OPEX) w przewidywalne inwestycje kapitałowe (CAPEX) oraz potrzebą zgodności z AI Act. Zamiast płacić za każdy token w chmurze, organizacje inwestują we własną infrastrukturę, co w dłuższej perspektywie drastycznie obniża TCO (Total Cost of Ownership).

- Prywatność i Suwerenność: Przetwarzanie on-device gwarantuje, że zapytania nigdy nie opuszczają lokalnej infrastruktury.

- Optymalizacja Kosztów: Eliminacja opłat za API zewnętrznych dostawców (OpenAI, Anthropic) dzięki rozwiązaniom typu AnythingLLM.

- Compliance i Audyt: Lokalna egzekucja ułatwia monitorowanie systemów sklasyfikowanych jako rozwiązania wysokiego ryzyka.

- Niezależność Narodowa: Projekty takie jak PLLuM udowadniają, że modele zoptymalizowane pod polską specyfikę mogą skutecznie wspierać instytucje publiczne bez dostępu do sieci.

Architektura Sprzętowa 2026: VRAM jako Kluczowa Waluta

W architekturze systemów AI 2026 to pojemność i przepustowość VRAM, a nie surowa moc CPU, definiuje granice możliwości Twojego lokalnego modelu. Dzięki technikom kwantyzacji (np. Q4_K_M), możliwe jest uruchamianie potężnych instancji na sprzęcie konsumenckim, jednak dobór GPU musi być precyzyjny, aby uniknąć wąskich gardeł w przepustowości.

Zestawienie Wydajności GPU dla Lokalnych Modeli

| Model GPU | VRAM | Przepustowość | Rekomendowane Zastosowanie |

| Dual RTX 5090 | 64 GB | 2x 1 792 GB/s | Komfortowa praca: Modele 70B+, MoE 235B |

| RTX 5090 | 32 GB | 1 792 GB/s | Qwen3-32B @ Q4 (Idealny balans) |

| RTX 4090 | 24 GB | 1 008 GB/s | Llama 3.1 70B @ Q4 (wymaga optymalizacji) |

| RTX 5080 | 16 GB | 960 GB/s | Modele 14B-27B, szybka asysta kodowania |

| RTX 3090 (Used) | 24 GB | 936 GB/s | Budżetowy wybór dla dużego okna kontekstowego |

Warto pamiętać, że sztuczna inteligencja offline wymaga również wsparcia jednostek NPU (np. 85 TOPS w układach Snapdragon), które przejmują zadania tła, takie jak transkrypcja mowy czy proste funkcje agentyczne, odciążając główne karty graficzne. Aby lepiej zrozumieć terminologię, polecam nasz słownik pojęć AI i LLM.

Ekosystem Oprogramowania: Od Interfejsu po Integrację

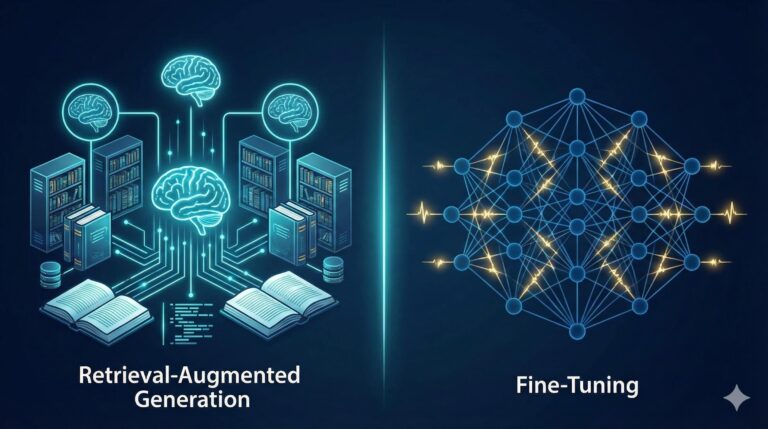

Dojrzałe narzędzia typu „runners” w 2026 roku oferują integrację na poziomie korporacyjnym, pozwalając na budowę baz wiedzy RAG w pełni lokalnie. Nie są to już eksperymentalne skrypty, ale stabilne środowiska pracy:

- LM Studio & Jan: Środowiska zgodne z API OpenAI, umożliwiające „podmianę” dostawcy modeli w istniejących narzędziach programistycznych.

- AnythingLLM: Strategiczne rozwiązanie do budowy baz wiedzy. Przetwarza PDF-y i repozytoria kodu bez wysyłania ich do chmury.

- Ollama: Standard wiersza poleceń, który dzięki systemowi Modelfile pozwala na precyzyjne definiowanie parametrów (temperature, system prompt).

Przełomowe Technologie: Efektywność bez Kompromisów

Innowacje takie jak modele 1.58-bitowe (BitNet) rewolucjonizują rynek, drastycznie obniżając zapotrzebowanie na energię i moc obliczeniową. Zamiast skomplikowanego mnożenia macierzy, nowoczesne sieci neuronowe w trybie offline mogą operować na systemie trójkowym {-1, 0, 1}, co przekłada się na 16-krotne przyspieszenie na standardowych procesorach CPU.

Dodatkowo, architektury 3-D FMA (Fused Multiply-Add) w nowych akceleratorach zwiększają wydajność energetyczną o blisko 159% w operacjach INT8. To kluczowy argument dla organizacji dążących do redukcji śladu węglowego przy zachowaniu maksymalnej wydajności lokalnej.

Integracja Systemowa: Apple, Windows i Inicjatywy Narodowe

W 2026 roku AI stało się integralną częścią jądra systemów operacyjnych, co sprawia, że sztuczna inteligencja offline jest dostępna „po wyjęciu z pudełka”.

- Apple Intelligence (macOS Tahoe): Framework on-device dający deweloperom bezpośredni dostęp do modeli fundamentowych.

- Windows 11 (2026): Funkcje takie jak Fluid Dictation czy zaawansowane Writing Assistance działają w pełni na jednostkach NPU, nie obciążając baterii laptopa.

- Projekt PLLuM: Polski model trenowany na 400 milionach dokumentów, zoptymalizowany pod kątem polskiej domeny urzędowej, minimalizujący ryzyko halucynacji w administracji publicznej.

Strategia Budowy Systemu AI: Rekomendacje 2026

Dobór odpowiedniej konfiguracji zależy od tego, czy planujesz korzystać z modeli typu MoE (Mixture of Experts), czy klasycznych jednostek Dense. Pamiętaj o złotych zasadach architekta:

- VRAM to fundament: To on definiuje rozmiar modelu, z którym możesz pracować.

- Kwantyzacja Q4_K_M: To obecnie standard zapewniający idealny balans między precyzją odpowiedzi a zajętością pamięci.

- Zasilanie i chłodzenie: Karty serii 5000 wymagają stabilnych zasilaczy 1000W+ i przemyślanej cyrkulacji powietrza w obudowie.

Sztuczna inteligencja offline nie jest już pieśnią przyszłości – to rzeczywistość, która oddaje władzę nad technologią w ręce użytkownika. Przyszłość inteligencji nie znajduje się w odległej chmurze, ale na Twoim własnym dysku, wewnątrz Twojej bezpiecznej infrastruktury.