Wykrywanie treści AI w 2026 roku: Fakty, których nie znają nawet profesjonaliści

W świecie, gdzie realizm cyfrowy przekracza granice ludzkiej percepcji, zaufanie staje się najcenniejszą walutą. Skuteczne wykrywanie treści AI przestało być domeną akademickich ciekawostek, a stało się fundamentem bezpieczeństwa cyfrowego. Podczas gdy globalne organizacje starają się odzyskać kontrolę nad prawdą, my jako użytkownicy stoimy przed wyzwaniem: jak odróżnić dzieło algorytmu od ludzkiego intelektu w dobie absolutnej perfekcji wizualnej?

Zamiast polegać na intuicji, branża technologiczna wdraża rozwiązania, które zmieniają paradygmat autentyczności. Poniższa analiza ujawnia cztery kluczowe fakty, które definiują dzisiejszy krajobraz transparentności w internecie.

Dlaczego tradycyjne detektory zawodzą w starciu z nowymi modelami

Większość dostępnych na rynku narzędzi do identyfikacji treści syntetycznych oferuje złudne poczucie bezpieczeństwa. Wykrywanie treści AI za pomocą prostych analizatorów statystycznych jest obecnie obarczone ogromnym marginesem błędu, gdzie prawdopodobieństwo fałszywych negatywów – czyli uznania tekstu maszyny za ludzki – sięga w skrajnych przypadkach nawet 100%.

Z naszego doświadczenia wynika, że problem leży w samej naturze ewolucji modeli językowych. Nowoczesne systemy są projektowane tak, aby minimalizować wzorce matematyczne, na których opierają się detektory. Poleganie wyłącznie na „procentowym wskaźniku sztuczności” jest ryzykowną strategią, szczególnie w kontekście edukacji czy dziennikarstwa. Aby zrozumieć, jak głęboko sięgają te zmiany, warto zapoznać się z naszym przewodnikiem po pojęciach LLM, który wyjaśnia mechanizmy stojące za generowaniem naturalnie brzmiącego języka.

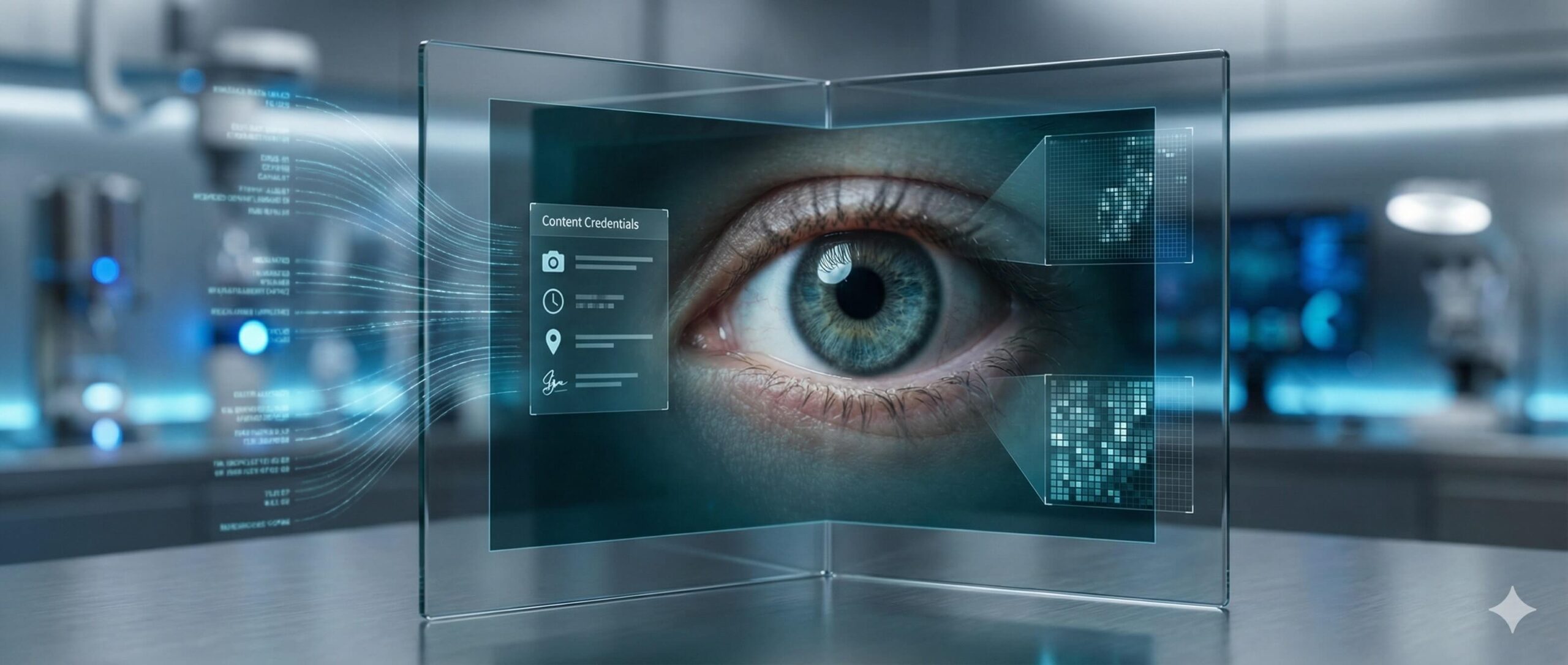

Standard Content Credentials jako nowa era transparentności

Przyszłość weryfikacji nie leży w próbach „złapania” algorytmu na błędzie, lecz w systemowym oznaczaniu pochodzenia informacji. Standard C2PA (Content Credentials), wspierany przez gigantów takich jak Adobe, Microsoft i Google, działa jak cyfrowa etykieta informacyjna. Zamiast pytać, czy obraz jest fałszywy, sprawdzamy jego kompletną ścieżkę edycji – od momentu naciśnięcia migawki w aparacie Leica po finalny eksport z programu graficznego.

To proaktywne podejście buduje zaufanie klasy Enterprise. Dzięki metadanym, których nie da się łatwo usunąć, użytkownik końcowy może w dowolnym momencie zweryfikować, czy dany materiał został zmodyfikowany przez narzędzia generatywne. Jest to szczególnie istotne w kwestiach związanych z plagiatem i prawami autorskimi, gdzie dowód pochodzenia staje się kluczowym argumentem prawnym.

Technologia SynthID i niewidzialne znaki wodne w pikselach

Google Cloud wprowadziło rozwiązanie, które przenosi wykrywanie treści AI na poziom mikroskopijny. Technologia SynthID osadza cyfrowe znaki wodne bezpośrednio w strukturze pikseli obrazu lub częstotliwościach audio. W przeciwieństwie do tradycyjnych metadanych, te oznaczenia są odporne na:

- Kompresję plików i zmianę formatu (np. z PNG na JPG).

- Przycinanie i zmianę rozmiaru obrazu.

- Nakładanie filtrów kolorystycznych.

Zastosowanie metodologii RAG (Retrieval-Augmented Generation) w systemach weryfikacji pozwala na porównywanie fragmentów treści z ogromnymi bazami danych pierwotnych w czasie rzeczywistym. Dzięki temu „uziemieniu” informacji, systemy bezpieczeństwa mogą z dużą precyzją wskazać, czy dany komunikat pochodzi z zaufanego źródła korporacyjnego, czy jest efektem halucynacji modelu.

Unikalna osobowość modeli jako klucz do identyfikacji

Mimo dążenia do doskonałości, każdy generator obrazów posiada swoją unikalną estetykę, którą eksperci nazywają „artystyczną osobowością”. Analizując strukturę szumu czy sposób renderowania tekstur, można dostrzec specyficzne cechy charakterystyczne dla konkretnych silników:

- MidJourney często wykazuje tendencję do artystycznej stylizacji i specyficznego operowania światłocieniem.

- HiDream stawia na hiperrealistyczne tekstury organiczne, takie jak śnieg czy ludzka skóra.

- Sora przenosi kinową głębię ostrości z formatów wideo na obrazy statyczne.

Zrozumienie tych niuansów wymaga głębokiej wiedzy o tym, jak działają sieci neuronowe. Rozpoznawanie „stylu maszyny” staje się nową formą krytyki artystycznej, pozwalającą na szybką, wstępną ocenę autentyczności materiału jeszcze przed użyciem specjalistycznych narzędzi technicznych.

Podsumowanie: Ku weryfikowalnej przyszłości

Skuteczne wykrywanie treści AI w 2026 roku nie jest już kwestią jednego narzędzia, ale całego ekosystemu zabezpieczeń. Od niewidzialnych znaków wodnych Google, przez standardy transparentności C2PA, aż po ekspercką wiedzę o specyfice poszczególnych modeli – tylko połączenie tych elementów pozwala na zachowanie integralności informacji w cyfrowym szumie.