Google NotebookLM Deep Research: Autonomiczny Agent

Google NotebookLM Deep Research to temat, który redefiniuje nasze podejście do pracy z informacją. Narzędzia AI w stylu „czatuj ze swoimi dokumentami” zyskały w ostatnich latach ogromną popularność, stając się podstawą codziennej pracy dla studentów, badaczy i profesjonalistów IT. Do tej pory działały one głównie jak pasywni asystenci: dostarczaliśmy im pliki, a one posłusznie odpowiadały na pytania, bazując wyłącznie na tym, co otrzymały.

Był to fundament trendu source-grounded AI – sztucznej inteligencji „uziemionej w źródłach”, która ogranicza ryzyko halucynacji. Jednak ta era reaktywnej technologii, choć użyteczna, stanowiła zaledwie wstęp. Obecnie na naszych oczach dokonuje się architektoniczna rewolucja. Pasywnych asystentów zastępują proaktywne systemy agentowe.

Mowa tu o autonomicznych partnerach zdolnych do samodzielnego prowadzenia złożonych procesów badawczych. Zamiast czekać na polecenie, potrafią planować, wykonywać i iterować zadania, aktywnie poszukując nowej wiedzy w sieci. Najlepszym przykładem tej transformacji jest Google NotebookLM Deep Research.

Krok dalej niż RAG: Czym jest „Agentowość” w Google NotebookLM Deep Research?

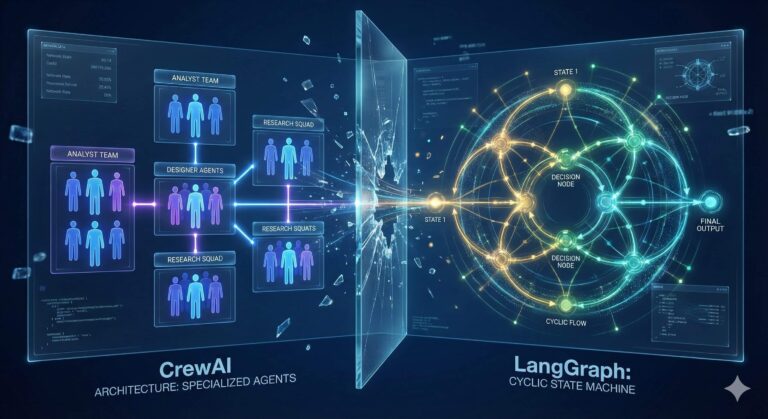

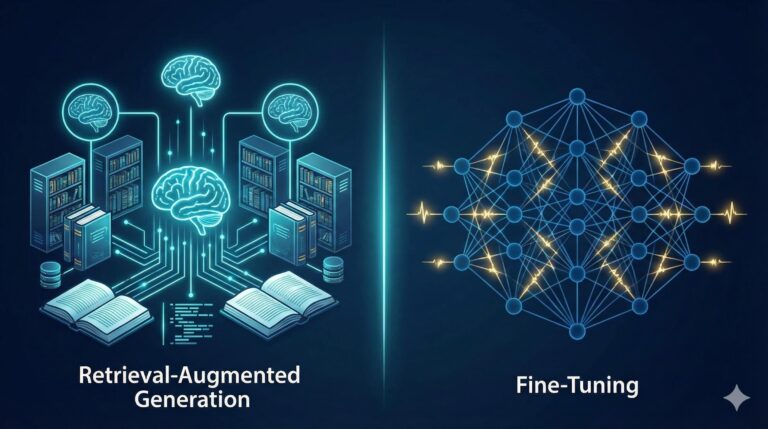

Aby w pełni docenić znaczenie tej ewolucji, musimy zrozumieć fundamentalną różnicę między tradycyjnym podejściem Retrieval-Augmented Generation (RAG) a nowym paradygmatem systemów agentowych. To nie jest drobna aktualizacja oprogramowania, lecz całkowite rozszerzenie możliwości poznawczych sztucznej inteligencji.

Tradycyjne narzędzia, w tym bazowa wersja NotebookLM, opierają się na architekturze RAG. Model ten działa niczym skrupulatny bibliotekarz, który odnajduje informacje wyłącznie w książkach umieszczonych w Twojej prywatnej bibliotece. Gdy zadajesz pytanie, system przeszukuje dostarczone dokumenty, odnajduje trafne fragmenty i syntetyzuje odpowiedź. Zaletą tego podejścia jest bezpieczeństwo danych i precyzja, ale jego ograniczeniem jest zamknięta baza wiedzy.

Różnice między podejściem klasycznym a agentowym

Poniższa tabela obrazuje kluczowe różnice między standardowym modelem pracy a nowym podejściem Deep Research:

| Cecha | Standardowy RAG | Agent Deep Research |

| Źródło danych | Tylko przesłane pliki użytkownika | Przesłane pliki + Otwarty Internet |

| Tryb działania | Reaktywny (odpowiada na pytanie) | Proaktywny (planuje badanie) |

| Zasięg | Ograniczony do bazy wiedzy | Nieograniczony (Web Search) |

| Proces | Jednoetapowa synteza | Wieloetapowa iteracja i weryfikacja |

Funkcja Google NotebookLM Deep Research, wspierana przez najnowsze modele Gemini, wprowadza koncepcję agenta badawczego. Taki agent to proaktywny partner, który „opuszcza bibliotekę”, by samodzielnie znaleźć nowe źródła, przeczytać je i wrócić z kompleksowym raportem.

Autonomicznie formułuje zapytania, analizuje wyniki, identyfikuje luki w wiedzy i ponawia wyszukiwanie. Ta „autonomiczna zdolność badawcza” to milowy krok w kierunku automatyzacji złożonych procesów intelektualnych. Więcej o definicjach takich jak „agent autonomiczny” przeczytasz w naszym Słowniku pojęć AI.

Jak działa Deep Research: Proces zamiast prostej odpowiedzi

Wartość agenta Deep Research nie leży w natychmiastowej odpowiedzi, ale w transparentnym, wieloetapowym procesie rozumowania. To odejście od modelu prostego czatu na rzecz symulacji pracy analityka.

Sercem tej funkcji jest silnik rozumowania oparty na Gemini 3 Pro – modelu zoptymalizowanym pod kątem faktualności. Zamiast podawać wynik od razu, agent iteracyjnie planuje swoje dochodzenie. Proces ten jest zaprojektowany pod kątem długotrwałego gromadzenia kontekstu.

Oto jak wygląda to w praktyce:

- Analiza zadania: Agent rozkłada Twoje zapytanie na czynniki pierwsze.

- Planowanie: Tworzy strategię wyszukiwania informacji.

- Weryfikacja: Działa niczym ludzki badacz, który krok po kroku buduje bazę wiedzy i weryfikuje hipotezy.

Za tą autonomią stoi technologia „wzmocnionego uczenia wieloetapowego na potrzeby wyszukiwania” (multi-step reinforcement learning for search). Pozwala ona na precyzyjne nawigowanie po skomplikowanych witrynach i wydobywanie danych głębiej niż standardowe wyszukiwarki.

Wynik końcowy: Portfolio ustrukturyzowanych danych

Efektem pracy w ekosystemie Google NotebookLM nie jest już tylko tekstowa odpowiedź. Użytkownik otrzymuje portfolio wiarygodnych produktów końcowych, gotowych do dalszego wykorzystania.

Po pierwsze, agent generuje szczegółowy raport tekstowy. Masz pełną kontrolę nad jego strukturą – za pomocą odpowiednich instrukcji możesz zdefiniować nagłówki czy podtytuły. Dla programistów kluczowa jest możliwość zdefiniowania wyniku w postaci schematu JSON, co ułatwia parsowanie danych przez zewnętrzne aplikacje.

Multimodalność w praktyce

Siła NotebookLM leży w jego zdolności do transformacji wiedzy w inne formaty. Poza raportem tekstowym platforma oferuje:

- Audio Overviews: Funkcja generuje dyskusję w stylu podcastu. Dwóch wirtualnych gospodarzy omawia kluczowe tezy ze źródeł, nadając informacjom formę łatwą do przyswojenia np. podczas podróży.

- Video Overviews: Tworzy narracyjne wideo (np. w stylu whiteboard), które wizualnie objaśnia złożone koncepcje.

- Materiały edukacyjne: Automatycznie generuje przewodniki do nauki (Study Guides), mapy myśli oraz gotowe talie slajdów.

Kluczowym elementem budującym zaufanie jest szczegółowe cytowanie (granular sourcing). Każde twierdzenie i każda liczba w raporcie są bezpośrednio powiązane z konkretnym źródłem. Pozwala to na błyskawiczną weryfikację informacji, co jest niezbędne w profesjonalnych zastosowaniach.

Strategia pętli: Jak maksymalizować efekty?

Zaawansowani użytkownicy stosują tak zwaną „strategię pętli” (loop strategy), aby pogłębić analizę tematu przy użyciu Google NotebookLM Deep Research. Polega ona na zapisywaniu kluczowych wniosków z wygenerowanych raportów jako notatek, a następnie dodawaniu tych notatek jako nowego źródła w notatniku.

Tworzy to rekurencyjny proces, w którym każda kolejna iteracja analizy opiera się na coraz bardziej przetworzonej i skondensowanej wiedzy. Przekształca to NotebookLM z prostego narzędzia w prawdziwego partnera do myślenia („thought partner”).

Oto dlaczego warto to robić:

- Zwiększasz precyzję kolejnych zapytań.

- Budujesz własną, unikalną bazę wiedzy.

- Pozwalasz AI na łączenie kropek między odległymi faktami.

Przyszłość LLM: Agentowe badania jako standard

Integracja Deep Research z NotebookLM to znacznie więcej niż nowa funkcja w menu. To zapowiedź zmiany w sposobie, w jaki biznes korzysta z modeli językowych.

Firmy takie jak Sonata Design już wykorzystują to narzędzie do tworzenia scentralizowanych baz danych ze specyfikacjami produktów. Efektem jest drastyczne zmniejszenie liczby pytań kierowanych do kadry kierowniczej, co usprawnia operacje i uwalnia czas ekspertów. Więcej o zastosowaniach biznesowych możesz przeczytać na oficjalnym blogu Google.

Google udostępnia te autonomiczne zdolności badawcze deweloperom również za pośrednictwem „Interactions API”. Oznacza to, że mechanizmy agentowe mogą być osadzane bezpośrednio w aplikacjach firm trzecich – od systemów CRM po platformy edukacyjne.